Introdução

Você sabia que até 80% do tempo de um analista de dados é gasto apenas limpando e organizando dados?

E pior: dados sujos — com campos incompletos, duplicatas ou formatos errados — geram decisões equivocadas e prejuízo.

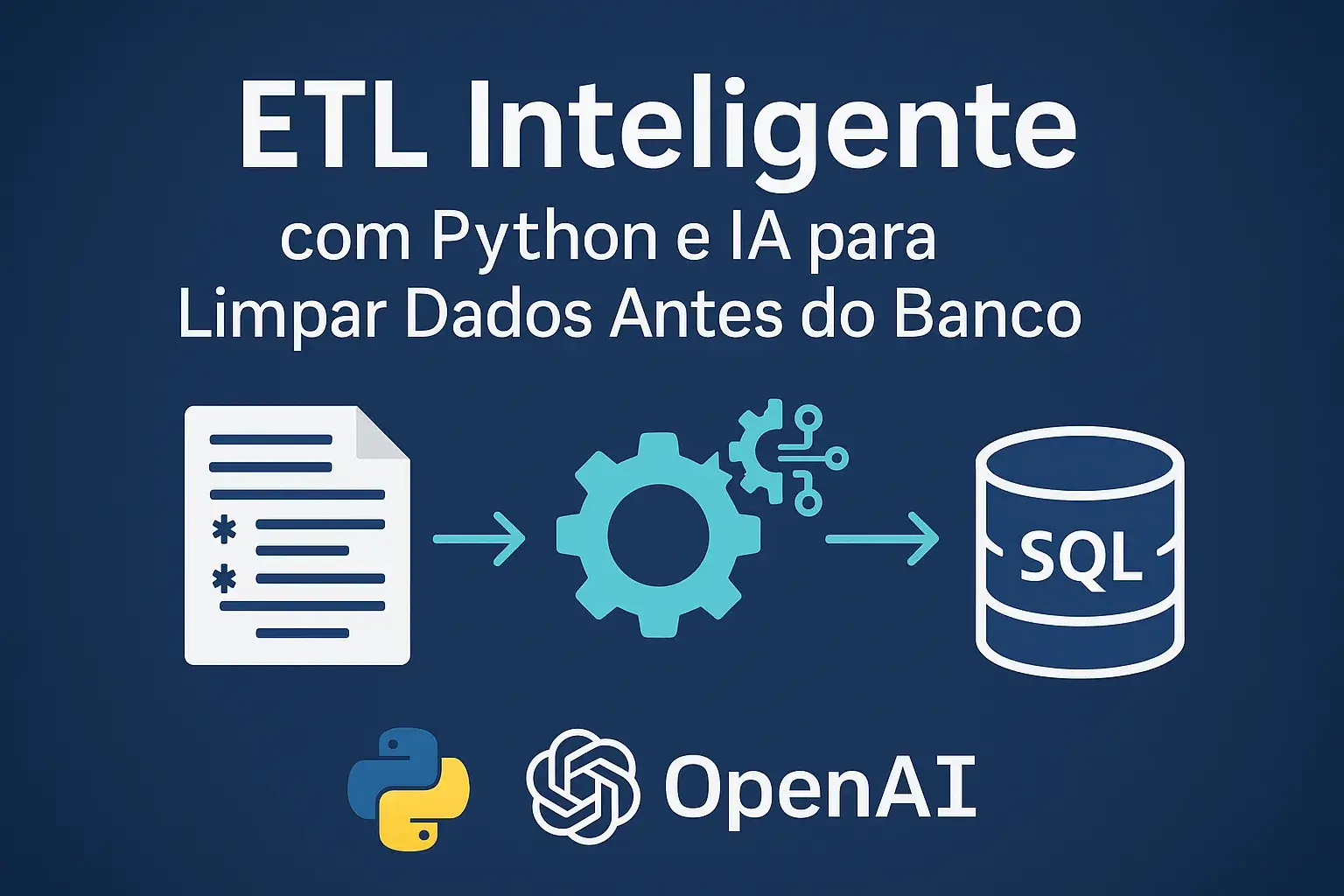

Pensando nisso, criamos um pipeline ETL inteligente usando Python e IA, que detecta e corrige erros automaticamente, padroniza formatos e carrega os dados limpos direto para um banco SQL.

📌 Confira o post no LinkedIn: Leia aqui

📂 Código no GitHub: Acesse o repositório

Objetivo do Projeto

O projeto tem como objetivo:

- Extrair dados de diferentes fontes (ex.: CSV, Google Sheets, APIs);

- Transformar aplicando limpeza com Python e IA;

- Carregar dados limpos em um banco PostgreSQL ou Supabase;

- Integrar com automações via n8n para fluxo contínuo.

Tecnologias Utilizadas

- Python → Limpeza e transformação de dados

- OpenAI API (ou modelos open-source) → Correção e padronização inteligente

- SQL → Criação e carga em banco

- PostgreSQL / Supabase → Armazenamento final

- n8n → Orquestração e automação

- GitHub → Controle de versão e código aberto

Fluxo ETL Inteligente

- Extração: leitura do arquivo

customers_raw.csv(simulação de dados reais sujos).

- Extração: leitura do arquivo

- Transformação:

- Normalização de e-mails

- Padronização de telefones no formato E.164

- Remoção de duplicatas

- Atribuição de score de qualidade

- Transformação:

- Carga: inserção no banco PostgreSQL ou Supabase.

- Automação: API exposta via FastAPI integrada ao n8n.

Antes vs Depois

O gráfico abaixo mostra o impacto da limpeza no dataset:

- E-mails inválidos caíram drasticamente

- Duplicatas praticamente eliminadas

- Qualidade geral dos dados melhorou

Como Usar

Clone o repositório:

git clone https://github.com/Rafael-Ferreira/etl-inteligente-python-ia.git

cd etl-inteligente-python-ia

Crie o ambiente:

python -m venv .venv

source .venv/bin/activate # Windows: .venv\Scripts\activate

pip install -r requirements.txt

python -m venv .venv

source .venv/bin/activate # Windows: .venv\Scripts\activate

pip install -r requirements.txt

Execute a limpeza:

python -m src.etl --input data/raw/customers_raw.csv --output data/clean/customers_clean.csv

Integração com n8n

- Importe o workflow

n8n/workflow_etl_demo.json

- Importe o workflow

- Configure o webhook

- Faça requisições POST enviando datasets para limpeza

Conclusão

Com este projeto, mostramos que é possível automatizar e otimizar o processo de limpeza de dados usando Python, IA e automação com n8n.

Assim, você ganha tempo, reduz erros e aumenta a confiabilidade das análises.

📌 LinkedIn: Post original

📂 GitHub: Código do projeto